1. Introduction

1. Dans sa Résolution A/HRC/RES/32/13

du 1er juillet 2016, le Conseil des droits

de l’homme des Nations Unies a affirmé que «[…] les droits dont

les personnes jouissent hors ligne doivent être aussi protégés en

ligne, en particulier le droit à la liberté d’expression, qui est

applicable indépendamment des frontières et quel que soit le média

que l’on choisisse, conformément aux articles 19 de la Déclaration

universelle des droits de l’homme et du Pacte international relatif

aux droits civils et politiques». Ce faisant, il rappelle ses Résolutions A/HRC/RES/20/8

du 5 juillet 2012 et A/HRC/RES/26/13 du 26 juin 2014 sur la question

de la promotion, de la protection et de la jouissance des droits

humains sur internet.

2. Internet est une plateforme technologique qui peut être utilisée

à différentes fins et proposer toute une gamme de services très

différents. À ce titre, internet ne peut pas être considéré comme

un média comparable à la presse, à la radio et à la télévision,

mais plutôt comme une plateforme de distribution propice aux interactions

entre plusieurs types de fournisseurs et d’utilisateurs.

3. En plus d’être un espace dédié à ce que l’on a coutume d’appeler

la communication publique, internet permet aussi d’exploiter différents

outils de communication privée (courrier électronique et services

de messagerie privée). Il a ainsi donné naissance à de nouvelles

formes hybrides de communication, qui présentent des caractéristiques

des deux (par exemple, les applications qui autorisent la création

de petits groupes ou de communautés et la diffusion interne de contenus).

4. Outre sa fonction de communication, internet se révèle par

ailleurs un outil très puissant pour faciliter le déploiement de

l’économie dite numérique. La pandémie de covid-19 a particulièrement

stimulé les achats en ligne ou l’offre dématérialisée de biens et

de services économiques, créant ainsi de nouveaux espaces où de nouveaux

modèles commerciaux peuvent prospérer.

5. Ces dernières années, une catégorie bien spécifique d’acteurs

en ligne a pris une place centrale dans la plupart des débats juridiques

et politiques.

6. En 2018, le Comité des Ministres du Conseil de l’Europe a

adopté une recommandation sur les rôles et les responsabilités des

intermédiaires d’internet

,

, évoquant

«une grande diversité d’acteurs dont le nombre ne cesse de s’étendre»

qui:

«facilitent

les interactions sur l’internet entre les personnes physiques et

morales en exerçant des fonctions diverses et en proposant des services

variés. Certains connectent les utilisateurs à l’internet, assurent

le traitement d’informations et de données ou hébergent des services

en ligne, y compris pour du contenu généré par les utilisateurs.

D’autres agrègent des informations et permettent de faire des recherches;

ils donnent accès à des contenus et des services conçus ou gérés

par des tiers, les hébergent et les indexent. Certains facilitent

la vente de biens et de services, notamment de services audiovisuels,

et rendent possibles d’autres transactions commerciales, y compris

les paiements.»

7. Les intermédiaires sont devenus des acteurs de premier plan

dans le processus de diffusion et de distribution de tout type de

contenus. Le terme «intermédiaires» recouvre un large éventail de

fournisseurs de services en ligne, dont le stockage, la distribution

et le partage en ligne, les médias sociaux, la collaboration et les

jeux, sans oublier la recherche et le référencement

.

8. Le présent rapport porte sur ce que l’on appelle communément

les fournisseurs de services d’hébergement, et en particulier sur

ceux qui ont tendance à s’engager dans la modération de contenu granulaire.

Cela comprend les services fournis par les plateformes de médias

sociaux comme Facebook ou Twitter, les plateformes de partage de

contenu comme YouTube ou Vimeo, et les moteurs de recherche comme

Google ou Yahoo.

9. Ces fournisseurs jouent un rôle important en tant que facilitateurs

de l’exercice du droit des usagers à la liberté d’expression. Pour

autant, il n’en demeure pas moins que le rôle et la présence des

intermédiaires en ligne soulèvent deux grandes questions. Premièrement,

la multiplicité des économies d’échelle, des économies de gamme

et des effets de réseau favorise un niveau élevé de concentration,

qui peut aussi conduire à d’importantes défaillances du marché.

Deuxièmement, les plus grands acteurs de ces marchés sont clairement

devenus de puissants contrôleurs d’accès aux principaux forums de

discussion. Comme dans le cas des acteurs concentrés – une question

qui reste à résoudre à bien des égards – exerçant un pouvoir de goulet

d’étranglement dans le champ des médias traditionnels (notamment

le secteur de la radiodiffusion), les valeurs telles que la dignité

humaine, le pluralisme, la liberté d’expression

doivent

faire l’objet d’une attention particulière et être au cœur des débats

juridiques et politiques sur la réglementation des plateformes.

10. L’objet du présent rapport est d’approfondir ces questions

en mettant particulièrement l'accent sur les possibilités de préserver

les valeurs susmentionnées, dans un contexte où aucune contrainte

inutile et disproportionnée n'est imposée et où différents modèles

commerciaux peuvent prospérer au profit des utilisateurs et de la

société dans son ensemble.

11. Mon analyse prend appui sur le rapport d’expert de M. Joan

Barata

, que je remercie chaleureusement pour

son travail remarquable. J’ai aussi pris en compte les contributions

d’autres experts

et

de plusieurs membres de la commission.

2. Les services d’hébergement: une activité

économique dotée de pouvoirs de contrôle

2.1. Les

plateformes et la domination du marché

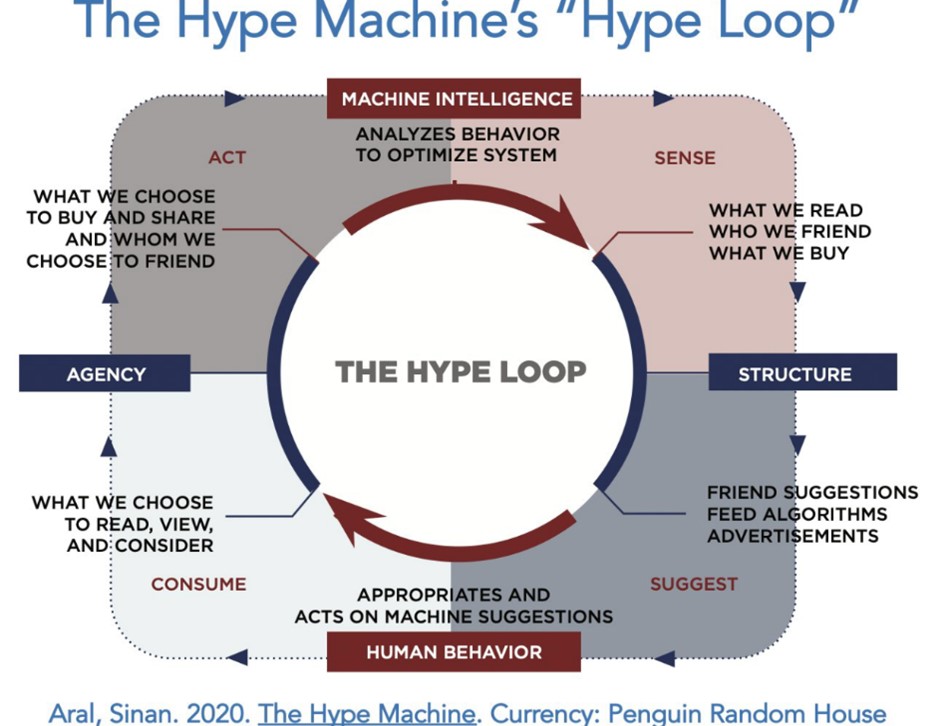

12. Les plateformes en ligne sont

de nouveaux acteurs particulièrement importants dans la sphère publique, principalement

au niveau de leur pouvoir de marché. Elles fonctionnent en s’appuyant

sur ce que l’on appelle les effets de réseau: plus une plateforme

a d’utilisateurs, plus les avantages pour les utilisateurs sont nombreux

et plus les services deviennent intéressants pour eux. Ces effets

de réseau sont transversaux, au sens où les avantages ou services

reçus par une partie des utilisateurs (les utilisateurs des médias

sociaux, par exemple) sont subventionnés par d’autres participants

(les annonceurs). Au vu de cette principale caractéristique, il

est évident que le succès de ces plateformes dépend de la captation

d’une masse critique et, à partir de là, de l’accumulation du plus

grand nombre possible d’utilisateurs finaux.

13. Dans un récent rapport sur les défaillances et les nuisances

du marché en ligne, l’autorité britannique de régulation OFCOM a

observé qu’outre les effets de réseau évoqués, les entreprises bénéficient d’économies

de coûts grâce à leur taille (économies d’échelle) ou à leur implantation

dans une gamme de services (économies de gamme)

. L’utilisation des données et des

algorithmes est un autre élément d’une grande importance économique.

En effet, la collecte de données relatives aux habitudes et aux caractéristiques

des utilisateurs permet non seulement d’améliorer l’expérience de

ces derniers grâce à des services personnalisés, mais aussi de proposer

des publicités plus ciblées à partir d’une connaissance approfondie

des préférences et besoins des consommateurs. Cela implique de collecter

le plus grand nombre de données possible auprès des utilisateurs,

tout en dissuadant ces derniers de rechercher d’autres services. En

plus de tous ces éléments, il convient de signaler que les modèles

commerciaux deviennent de plus en plus complexes et sophistiqués,

les grandes plateformes en ligne combinant souvent plusieurs offres

de services: médias sociaux, recherche, places de marché, partage

de contenu, etc. De ce fait, l’identification des marchés pertinents

aux fins de l’évaluation de la concurrence peut devenir éminemment

complexe.

14. Toujours d’un point de vue strictement économique, les effets

de réseau et les économies d’échelle créent une forte tendance à

la concentration du marché. Dans ce contexte de concurrence oligopolistique induite

par la technologie, les inefficacités et les défaillances du marché

peuvent s’expliquer par l’utilisation du pouvoir de marché pour

décourager l’entrée de nouveaux concurrents, par la création d’obstacles

au changement de service ou par les asymétries d’information

.

15. En juin 2019 aux États-Unis, la commission judiciaire de la

Chambre des représentants a lancé une enquête bipartite sur la concurrence

des marchés numériques. La sous-commission sur les lois antitrust,

le droit commercial et le droit administratif s’est intéressée à

la position dominante d’Amazon, Apple, Facebook et Google ainsi

qu’à leurs pratiques commerciales, afin de comprendre comment leur

pouvoir affecte l’économie et la démocratie américaines. Par ailleurs,

la sous-commission a passé en revue les lois antitrust existantes,

les politiques publiques sur la concurrence et les niveaux actuels

d’application afin de déterminer leur efficacité pour faire face

au pouvoir de marché et aux comportements anticoncurrentiels observés

sur les marchés numériques. Les membres de la sous-commission ont

identifié un vaste éventail de réformes à étudier de manière plus

approfondie en vue de préparer de nouvelles initiatives législatives.

Ces réformes porteraient notamment sur la lutte contre les comportements

anticoncurrentiels sur les marchés numériques, le renforcement de

l’application des lois sur les fusions et la monopolisation, et

l’amélioration de l’application des lois antitrust par d’autres

réformes

.

16. Au niveau de l’Union européenne, les commissaires européens

Margrethe Vestager et Thierry Breton ont présenté mi-décembre 2020

deux grandes propositions législatives: la législation sur les services numériques

et la législation sur les marchés numériques

. La législation sur les marchés

numériques vise à harmoniser les réglementations en vigueur dans

les États membres afin de prévenir plus efficacement la formation

de goulets d’étranglement et l’imposition de barrières à l’entrée

du marché unique numérique

.

2.2. Les

plateformes et le pouvoir informationnel

17. Le pouvoir des plateformes

en ligne dépasse le seul cadre économique. Même aux États-Unis,

où les décisions prises par les plateformes qui affectent – et parfois

restreignent – la liberté d’expression bénéficient d’une solide

protection constitutionnelle, la Cour suprême a déclaré que les

plateformes de médias sociaux servaient de «place publique moderne»,

offrant à de nombreuses personnes leurs «principales sources d’information

sur l’actualité» et un moyen d’explorer «la pensée et les connaissances

humaines»

.

18. Les dispositions légales et réglementaires qui s’appliquent

aux discours hors ligne doivent en principe être également appliquées

et mises en œuvre pour les discours en ligne, y compris les contenus

diffusés via les plateformes en ligne. L’application de restrictions

légales générales en matière de contenu vis-à-vis des plateformes

en ligne – et la responsabilité qui en découle – constitue un domaine

spécifique de dispositions juridiques qui, en Europe, est principalement

couvert par la directive sur le commerce électronique (dans le cas de

l’Union européenne

)

et les normes établies par le Conseil de l’Europe. L’annexe à la

Recommandation CM/Rec(2018)2 du Comité des Ministres aux États membres

sur les rôles et les responsabilités des intermédiaires d’internet,

déjà citée, précise que toute législation «devrait définir clairement

les pouvoirs accordés aux autorités publiques à l’égard des intermédiaires

d’internet, en particulier lorsque ces pouvoirs sont exercés par

les forces de l’ordre» et que toute action des autorités publiques

adressée à des intermédiaires d’internet qui pourrait entraîner

une limitation de l’exercice de la liberté d’expression, doit respecter

les «trois tests» énoncés à l’article 10 de la Convention européenne

des droits de l’homme (STE no 5).

19. Par ailleurs, les fournisseurs d’hébergement modèrent généralement

les contenus selon leurs propres règles privées. La modération des

contenus consiste en une série de mécanismes de gouvernance qui structurent

la participation à une communauté afin de faciliter la coopération

et de prévenir les abus. Les plateformes cherchent à promouvoir

la bonne tenue des débats et des interactions afin de faciliter

la communication entre utilisateurs

. Elles prennent ces décisions sur

la base d’une série de principes et de normes internes. Parmi les

exemples de ces systèmes de modération, citons les standards de

la communauté Facebook

, les règles et politiques de Twitter

ou le règlement de la communauté

YouTube

. Dans tous les cas, il est clair

que les plateformes ont le pouvoir de façonner et de réglementer

le discours en ligne au-delà des dispositions du droit national,

et ce de manière très puissante. La suspension unilatérale des comptes

de l’ancien président des États-Unis Donald Trump sur plusieurs

grandes plateformes de médias sociaux en a été une manifestation

évidente. Le pouvoir discrétionnaire dont disposent les entreprises

d’envergure mondiale comptant des milliards d’utilisateurs pour

fixer et interpréter les règles privées qui régissent le discours

légal est considérable. Ces règles ont une incidence à la fois locale

et mondiale sur la façon dont les faits, les idées et les opinions

sur diverses questions d’intérêt public sont diffusés.

20. De nombreux auteurs et organisations ont alerté sur le fait

que les intermédiaires font la promotion de contenus afin de maximiser

l’implication et la dépendance des utilisateurs, le ciblage comportemental

et une certaine polarisation

. D’un autre côté, il convient aussi

de préciser que la compréhension par le public des opérations de

suppression de contenu des plateformes, même parmi les chercheurs

spécialisés, reste limitée et que ce déficit d’information laisse

les décideurs relativement démunis pour répondre aux préoccupations relatives

aux plateformes, au discours en ligne et à la démocratie. Si des

améliorations récentes concernant la divulgation d’informations

par les entreprises ont pu atténuer ce problème, il reste encore

beaucoup à faire

. Cela

étant dit, il y a aussi lieu de signaler que les grandes plateformes

ont déjà un lourd passif de décisions de modération erronées ou

préjudiciables à l’égard de contenus terroristes ou extrémistes

.

21. Les plateformes ne se contentent pas de fixer et d’appliquer

des règles privées concernant le contenu publié par leurs utilisateurs.

Elles mènent également des activités de surveillance approfondies

au sein de leurs propres espaces et jouent un rôle fondamental dans

la détermination des contenus

visibles en

ligne et des contenus qui, bien que publiés, restent cachés ou peu

connus. Certes, les utilisateurs sont libres de choisir directement

le contenu fourni par les fournisseurs d’hébergement en ligne (accès

aux profils et aux pages des autres utilisateurs, outils de recherche,

intégration, etc.); pour autant, les propres systèmes de recommandation

des plateformes sont extrêmement influents dans la mesure où ils

occupent une place centrale dans leurs interfaces et sont devenus

des éléments incontournables de la découverte de contenu

. Étant donné que les résultats finaux

des recommandations sont le fruit d’une interaction bilatérale entre

les utilisateurs – leurs préférences, leurs préjugés, leurs antécédents,

etc. – et les systèmes de recommandation eux-mêmes, il importe de

ne pas négliger le rôle majeur de contrôleur d’accès joué par ces

derniers dans la hiérarchisation, l’amplification ou la restriction

des contenus.

22. Sur la base des considérations

précédentes, il convient de souligner, premièrement, qu’aucun système de

recommandation n’est ou ne peut être considéré comme fonctionnant

sur une base totalement neutre, ni prédéterminé dans ce sens. Cela

tient non seulement à l’influence des préférences des utilisateurs,

mais aussi au fait que les politiques de contenu des plateformes

sont souvent fondées sur un mélange complexe de différents principes:

stimuler l’engagement des utilisateurs, respecter certaines valeurs

d’intérêt public – qu’elles soient véritablement cultivées par les

plateformes ou qu’elles résultent de pressions exercées par les décideurs

et les législateurs – ou adhérer à une notion précise du droit à

la liberté d’expression. En réalité, le seul cas où des politiques

de modération de contenus pourraient être qualifiées de «neutres»

serait probablement l’absence de telles politiques. Toutefois, demander

aux plateformes d’héberger – sans catégorisation ni critères préétablis –

une masse de contenus bruts soumis à la seule exigence de respecter la

loi reviendrait à les transformer en dépotoirs où spams, désinformation,

pornographie, pro-anorexie et autres informations nuisibles seraient

constamment proposés à l’utilisateur. Ce scénario n’est guère séduisant,

ni pour les utilisateurs ni pour les entreprises. En outre, l’expérience

de ce type d’initiatives – comme 4chan ou 8chan aux États-Unis –

a montré que, parmi d’autres options, les plateformes de cette nature

sont souvent utilisées par des groupes qui défendent des valeurs

antidémocratiques, remettent en cause la légitimité des processus

électoraux et diffusent des contenus contraires aux principes fondamentaux

de la dignité humaine – du moins de la manière dont ce principe

est compris et protégé en Europe.

23. Deuxièmement, quelle que soit la précision avec laquelle un

outil automatisé, algorithmique ou même d’apprentissage automatique

est conçu, il peut être arbitrairement difficile de prédire ce qu’il

peut faire. Il n’est pas rare d’obtenir des résultats imprévus,

et les facteurs et les dysfonctionnements qui les provoquent ne peuvent

être corrigés qu’une fois détectés. Certains de ces résultats ne

sont pas sans menacer gravement les droits humains, notamment en

ce qui concerne le durcissement de situations discriminatoires:

un article scientifique sur les technologies de détection du langage

abusif a révélé les preuves d’un biais racial systématique, dans

tous les ensembles de données, contre les tweets écrits en anglais

afro-américain, ce qui crée un risque évident de traitement négatif

disproportionné du discours des utilisateurs afro-américains des médias

sociaux

.

24. La troisième observation renvoie à la notion d’irréductibilité

informatique (

computational irreducibility)

en rapport avec les ensembles de règles éthiques/juridiques. En

résumé, on ne peut pas raisonnablement s’attendre à ce qu’un ensemble

fini de principes ou de règles informatiques qui contraignent les

systèmes automatisés de sélection de contenus se comporte toujours

exactement en fonction d’un système raisonnable de principes et

de règles juridiques et/ou éthiques, ni à ce qu’il serve ses objectifs.

Les normes informatiques généreront toujours de nouveaux cas imprévus

et de nouveaux principes devront donc être définis pour les gérer

.

2.3. Des

exemples précis: la désinformation et les élections

25. Le présent rapport ne peut

pas couvrir le phénomène de désinformation, de malinformation et

de mésinformation sous toutes ses dimensions.

26. La notion de désinformation, qui est la plus répandue, couvre

les discours qui ne relèvent pas des formes de discours déjà illégales

(diffamation, discours de haine, incitation à la violence), mais

qui peuvent néanmoins être néfastes

. D’après la Commission européenne,

la désinformation désigne les informations dont on peut vérifier

qu’elles sont fausses ou trompeuses, qui sont cumulativement créées,

présentées et diffusées dans un but lucratif ou dans l’intention

délibérée de tromper le public, et qui sont susceptibles de causer

un préjudice public

. Elle est dans tous les cas problématique,

car elle a une incidence directe sur la démocratie, elle affaiblit

le journalisme et certaines formes de médias traditionnels, elle

crée d’importantes bulles de filtre et chambres d’écho, elle peut

rejoindre des formes hybrides d’agression internationale via l’utilisation

de médias contrôlés par l’État, elle crée son propre mécanisme d’incitation

financière, elle engendre un certain tribalisme politique et elle

peut être facilement automatisée. La lutte contre la désinformation,

surtout lorsqu’elle est diffusée par des plateformes en ligne, doit

passer par une analyse large et complète intégrant des perspectives,

des principes et des intérêts divers et complémentaires.

27. Par ailleurs, il convient également de noter que le problème

n’est pas tant le phénomène de désinformation ou les

fake news en tant que tel, mais

plutôt les effets qui en découlent – à savoir la manipulation du

public, souvent à des fins politiques (mais pas nécessairement)

. Par conséquent, plutôt que de vouloir

réglementer le contenu de la désinformation, il semble important

d’orienter les règles sur les causes et les conséquences de celle-ci

. Comme l’a indiqué la Rapporteuse

spéciale des Nations Unies sur la promotion et la protection du

droit à la liberté d’opinion et d’expression, Irene Khan, dans son

premier rapport présenté au Conseil des droits de l’homme sur les

menaces que fait peser la désinformation sur les droits humains,

les institutions démocratiques et le processus de développement

, «la désinformation tend à prospérer

là où les droits de l’homme sont réprimés, où le régime d’information

publique manque de robustesse et où la qualité, la diversité

et l’indépendance des médias sont faibles».

28. La désinformation étant directement liée au droit à la liberté

d’expression, une attention excessive portée aux mesures juridiques,

et en particulier aux mesures restrictives, pourrait avoir des effets

regrettables sur le libre-échange d’idées et les libertés individuelles.

D’après la Déclaration conjointe sur la liberté d’expression, les

«fausses informations», la désinformation et la propagande, adoptée

le 3 mars 2017 par le Rapporteur spécial, le Représentant sur la

liberté des médias de l’Organisation pour la sécurité et la coopération

en Europe (OSCE), le Rapporteur spécial sur la liberté d’expression

de l’Organisation des États américains (OEA) et le Rapporteur spécial

sur la liberté d’expression et l’accès à l’information de la Commission

africaine des droits de l’homme et des peuples (CADHP)

, les interdictions générales de

diffusion d’informations fondées sur des notions vagues et ambiguës,

y compris les «fausses nouvelles» ou les «informations non objectives»,

sont incompatibles avec les normes internationales relatives aux

restrictions à la liberté d’expression. Les acteurs étatiques ne

doivent pas faire, parrainer, encourager ou diffuser des déclarations

dont ils savent ou doivent raisonnablement savoir qu’elles sont

fausses (désinformation) ou qui témoignent d’un mépris imprudent

pour des informations vérifiables (propagande). Les acteurs étatiques

doivent, conformément à leurs obligations juridiques nationales

et internationales et à leurs devoirs publics, veiller à diffuser

des informations fiables et dignes de foi, notamment sur des questions

d’intérêt public telles que l’économie, la santé publique, la sécurité et

l’environnement. Enfin, les autorités publiques doivent promouvoir

un environnement de communication libre, indépendant et diversifié,

y compris la diversité des médias, assurer la présence de médias

de service public forts, indépendants et dotés de ressources suffisantes,

et prendre des mesures pour promouvoir l’éducation aux médias et

au numérique.

29. À cet égard, de nombreux experts et organisations internationales

ont particulièrement mis en garde contre la façon dont les «désordres

de l’information» (selon la terminologie du Conseil de l’Europe

) venaient bouleverser l’écosystème

de la communication au point d’affecter gravement les électeurs

dans leurs décisions par des informations trompeuses, manipulatrices

ou fausses destinées à influencer leur vote

.

Les principaux facteurs de risque dans ce contexte sont les suivants:

le manque de transparence des nouvelles formes de publicité en ligne,

qui peuvent trop facilement échapper aux restrictions applicables

à la publicité sur les médias traditionnels, telles que celles destinées

à protéger les enfants, la morale publique ou d'autres valeurs sociales;

le fait que les journalistes, dont le comportement est guidé par

des pratiques éditoriales saines et des obligations éthiques, ne

sont plus ceux qui jouent le rôle de contrôleurs d’accès; et l'éventail croissant

de désinformations, y compris d'informations électorales, disponibles

en ligne, en particulier lorsqu'elles sont diffusées stratégiquement

dans le but d'influencer les résultats des élections.

3. Les

solutions possibles

30. Je présenterai dans les paragraphes

suivants les grands principes, valeurs et normes des droits de l'homme

qui, selon moi, pourraient être envisagés pour trouver des solutions

appropriées et adéquates aux différents problèmes mentionnés ci-dessus.

31. En ce qui concerne le pouvoir économique des plateformes,

il importe d’évaluer si le droit général de la concurrence peut

être utile pour traiter tout ou partie de ces questions, sans pour

autant négliger le fait, déjà évoqué, que l’identification des marchés

pertinents aux fins de l’évaluation de la concurrence peut devenir particulièrement

complexe. La diversité et la flexibilité des modèles commerciaux

et des services proposés par un vaste éventail de plateformes rendent

nécessaire une analyse au cas par cas ainsi que l’examen éventuel de

solutions adaptées ex post, telles que la portabilité des données

ou l’interopérabilité des plateformes, par exemple. Il convient

d’étudier et de définir soigneusement les interventions possibles

afin d’éviter tout résultat involontaire et préjudiciable, notamment

en ce qui concerne les incitations à l’entrée et à l’innovation.

32. Il est important de rappeler qu’un petit nombre de solutions

innovantes pour atténuer le pouvoir des plateformes ont déjà été

présentées par des experts de ce que l’on peut appeler le «choix

algorithmique». Ces solutions consistent notamment à donner aux

utilisateurs la possibilité de recourir aux services de fournisseurs de

classement tiers de leur choix (pas ceux de la plateforme qu’ils

utilisent), qui peuvent utiliser d’autres méthodes et mettre l’accent

sur d’autres types de contenu; ou à laisser aux utilisateurs le

choix d’appliquer les critères de fournisseurs tiers, qui affichent

un contenu selon un classement préalablement effectué par les utilisateurs

eux-mêmes

.

Dans une contribution récente, Francis Fukuyama et d’autres auteurs

proposent que la réglementation oblige les plateformes en ligne

à permettre aux utilisateurs d’installer ce que l’on appelle communément

un «intergiciel». Il s’agit d’un logiciel fourni par un tiers et

incorporé aux plateformes dominantes, destiné à traiter et à trier

le contenu présenté aux utilisateurs. Cela pourrait ouvrir la porte

à un groupe diversifié d’entreprises concurrentielles susceptibles

de personnaliser l’expérience virtuelle des utilisateurs. De l’avis

des auteurs, cela atténuerait le contrôle éditorial – considérable

à l’heure actuelle – des plateformes sur le contenu et l’étiquetage

ou la censure des discours et permettrait à de nouveaux fournisseurs d’innover

et de proposer des services qui sont actuellement dominés par les

plateformes (marchés des intergiciels)

. Cette solution soulève un grand

nombre de questions intéressantes, mais sa mise en œuvre ne doit

pas ignorer plusieurs dimensions importantes, notamment en ce qui

concerne la protection des données.

33. La législation peut réglementer le filtrage (par tout moyen,

humain, automatisé ou les deux) en obligeant les plateformes à filtrer

certains contenus, sous certaines conditions, ou en interdisant

le filtrage d’autres contenus. Une telle réglementation aurait pour

but ultime d’influencer le comportement des utilisateurs en imposant

des obligations aux plateformes

. Ce type de législation doit contenir

suffisamment de garanties pour que les effets recherchés ne portent

pas atteinte de manière inutile et disproportionnée aux droits humains,

notamment à la liberté d’expression. En tout état de cause, toute

législation imposant des obligations et des restrictions aux plateformes

et ayant une incidence supplémentaire sur le discours des utilisateurs

doit viser exclusivement à lutter contre les contenus illicites

et éviter les notions plus larges telles que les «contenus préjudiciables».

En d’autres termes, elle ne peut pas autoriser ni établir des interventions

de l’État qui seraient autrement interdites si elles étaient appliquées

à d’autres moyens de diffusion ou de publication de contenu.

34. En ce qui concerne l’utilisation de l’intelligence artificielle

et des filtres automatisés en général pour la modération de contenu,

il importe de comprendre qu’aujourd’hui, dans les principaux domaines

de la modération, la technologie de pointe n’est ni fiable ni efficace.

Les décideurs politiques doivent également reconnaître le rôle des

utilisateurs et des communautés dans la création et la diffusion

de contenus préjudiciables. Les solutions aux défis politiques que

sont les discours de haine, la propagande terroriste et la désinformation

sont forcément multidimensionnelles. Dès lors, rendre la modération

automatisée obligatoire par la loi est une réponse inadaptée et

incomplète

. Il est également important de bien

identifier et préciser le rôle et la présence nécessaire des décideurs

humains

, ainsi que la participation des utilisateurs

et des communautés dans l’établissement et l’évaluation des politiques

de modération de contenu

.

35. En ce qui concerne le cas spécifique des processus électoraux,

la Commission européenne pour la démocratie par le droit (Commission

de Venise) a recommandé une série de mesures: la révision des règles et

règlements sur la publicité politique en matière d’accès aux médias

et de dépenses; le renforcement de la responsabilité des intermédiaires

d’internet en matière de transparence et d’accès aux données; la

promotion d’un journalisme de qualité; et l’autonomisation des électeurs

vers une évaluation critique des actions de communication électorale

afin de prévenir l’exposition à des informations fausses, trompeuses

et préjudiciables, ainsi que vers l’acquisition de connaissances

dans le domaine numérique par l’éducation et la sensibilisation

.

36. Outre les instruments juridiques, plusieurs organisations

gouvernementales et non gouvernementales aux niveaux national, régional

et international ont élaboré des lignes directrices en matière d’éthique

ou d’autres instruments de droit souple sur l’intelligence artificielle,

au sens large. Bien qu’il n’y ait toujours pas de consensus autour

des règles et des principes que pourrait comporter un système d’éthique

de l’intelligence artificielle, la plupart des codes sont fondés

sur les principes de transparence, de justice, de non-malfaisance, de

responsabilité et de respect de la vie privée

.

Le Comité consultatif de la Convention du Conseil de l’Europe pour

la protection des personnes à l’égard du traitement automatisé des

données à caractère personnel (STE no 108,

«Convention 108») a adopté le 25 janvier 2019 les «Lignes directrices

sur les incidences de l’intelligence artificielle sur la protection

des données». Elles sont fondées sur les principes de la Convention

et plus particulièrement sur la licéité et la loyauté du traitement,

la définition de la finalité, la proportionnalité du traitement

des données, la prise en compte de la protection des données dès

la conception (

privacy by-design)

et par défaut, la responsabilité et la démonstration de la conformité

(

accountability), la transparence,

la sécurité des données et la gestion du risque

.

37. Le 8 avril 2020, le Comité des Ministres du Conseil de l’Europe

a adopté sa Recommandation CM/Rec(2020)1 aux États membres sur les

impacts des systèmes algorithmiques sur les droits humains. Cette recommandation

réaffirme avant tout que les normes de primauté du droit qui régissent

les relations publiques et privées, comme la légalité, la transparence,

la prévisibilité, la responsabilité et la surveillance, doivent également

être préservées dans le contexte des systèmes algorithmiques. Elle

rappelle également que lorsque les systèmes algorithmiques sont

susceptibles d’avoir des effets négatifs sur les droits humains,

y compris sur les processus démocratiques ou sur l’État de droit,

ces effets engagent les obligations des États et les responsabilités

du secteur privé vis-à-vis des droits humains. Elle établit donc

une série d’obligations pour les États à l’égard des cadres juridiques

et institutionnels; de la gestion des données; de l’analyse et de la

modélisation; de la transparence, de la responsabilité et des recours

effectifs; des mesures de précaution (y compris les études d’impact

sur les droits humains); et de la recherche, de l’innovation et

de la sensibilisation du public. Outre les responsabilités des États,

la recommandation énumère également celles qui incombent aux acteurs

du secteur privé dans les domaines déjà cités et en particulier

le devoir de diligence raisonnable en matière de droits humains.

38. La Commission européenne, en réponse aux demandes et exigences

répétées des autres institutions de l’Union européenne, de la société

civile et de l’industrie, a récemment proposé un nouvel ensemble

de règles concernant l’utilisation de l’intelligence artificielle.

De l’avis de la Commission, ces règles renforceront la confiance

des citoyens dans l’intelligence artificielle, les entreprises gagneront

en sécurité juridique et les États membres ne verront aucune raison

de prendre des mesures unilatérales susceptibles de fragmenter le marché

unique

. Il n’est pas possible de décrire

et d’analyser la proposition dans le cadre du présent rapport. Il

convient de noter toutefois qu’elle intègre essentiellement une

approche fondée sur le risque, sur la base d’une définition horizontale

et prétendument évolutive de l’intelligence artificielle. Fondée

sur différents niveaux de risque (risque inacceptable, risque élevé,

risque limité et risque minime), la proposition présente une série d’obligations

graduées, en tenant particulièrement compte des impacts possibles

sur les droits humains. La Commission propose que les autorités

nationales compétentes en matière de surveillance du marché supervisent

les nouvelles règles, dont la mise en œuvre sera facilitée par la

création d’un comité européen de l’intelligence artificielle. La

proposition prévoit en outre le recours à des codes de conduite

facultatifs dans certains cas.

39. Les entités qui ont recours à l’automatisation dans la modération

de contenu doivent être tenues d’exercer une plus grande transparence

sur leur utilisation de ces outils et les conséquences qu’ils ont

sur les droits des utilisateurs

. Ces règles doivent être en mesure

d’inciter à leur application pleine et concrète

. Avant d’adopter une règle ou un

règlement juridique, il convient d’avoir une compréhension correcte

et commune du type d’informations qu’il est nécessaire et pertinent

de divulguer par le biais des obligations de transparence, ainsi

que des intérêts publics qui légitiment ces obligations. Par ailleurs,

les organisations de la société civile et les régulateurs doivent

pouvoir disposer de connaissances et d’une expertise suffisantes

pour évaluer correctement les informations qu’ils sont susceptibles

de demander dans le cadre de leurs fonctions et responsabilités.

La législation sur les services numériques proposée au niveau de

l’Union européenne comprend des dispositions remarquables visant

à établir des obligations de transparence vis-à-vis des plateformes

en ligne –graduées en fonction de leur taille. Ces obligations de

transparence portent notamment sur les conditions générales (article

12), les activités de modération du contenu et les utilisateurs

(articles 13 et 23), l’exposé des motifs des décisions de désactiver

l’accès ou de supprimer certains éléments de contenu spécifiques

(article 15), la publicité en ligne (article 24) et les systèmes

de recommandation (article 29).

40. La transparence des recommandations sur les médias sociaux

a été classée en trois grandes catégories: les divulgations destinées

aux utilisateurs, qui visent à canaliser les informations vers les utilisateurs

individuels afin de les responsabiliser par rapport au système de

recommandation de contenu; la surveillance gouvernementale, qui

désigne une entité publique chargée de contrôler les systèmes de recommandation

pour vérifier leur conformité aux normes réglementées par l’État;

et les partenariats avec le monde universitaire et la société civile,

qui permettent à ces parties prenantes d’effectuer des recherches

et de critiquer les systèmes de recommandation. Outre ces domaines,

les experts ont également plaidé en faveur d’un régime solide en

ce qui concerne l’accès du public

.

41. D’autres domaines sont concernés par la transparence dans

la conception et l’utilisation de l’intelligence artificielle. Premièrement,

on peut citer la relation entre le développeur et l’entreprise:

les deux parties doivent partager des informations et avoir une

compréhension commune du système à développer et des objectifs qu’il va

remplir. Deuxièmement, aussi précises et ciblées que soient les

obligations légales et réglementaires, il pourrait être important

de pouvoir compter sur des mécanismes de contrôle appropriés indépendants

(visant également à éviter de longues procédures contentieuses devant

les tribunaux), capables d’examiner toute demande spécifique de

transparence pour protéger efficacement certains domaines d’intérêt

public ou privé légitime (par exemple, la protection des secrets

commerciaux). Troisièmement, les mécanismes de contrôle indépendants

doivent s’appuyer sur des outils appropriés d’évaluation des résultats

(tant au niveau quantitatif que qualitatif) afin d’examiner minutieusement

l’opportunité et l’efficacité des règles en place. Ces outils doivent

porter en particulier sur l’identification des dysfonctionnements,

des résultats imprévus (faux positifs) et des impacts sur les droits

humains.

4. Conclusions

42. La communication en ligne est

devenue un élément essentiel de la vie quotidienne des citoyens.

C’est pourquoi il est inquiétant de constater qu’une petite poignée

d’intermédiaires d’internet contrôlent de

facto les flux d’informations en ligne. Cette concentration

entre les mains de quelques sociétés privées leur donne un pouvoir

démesuré dans les domaines économique et technologique, ainsi que

la possibilité d’influer sur presque tous les aspects de la vie

privée et sociale des gens.

43. Pour remédier à la domination de quelques intermédiaires d’internet

sur le marché numérique, les États membres devraient recourir à

la législation antitrust. Cela peut permettre aux citoyens d'avoir

un plus grand choix lorsqu'il s'agit de sites qui protègent leur

vie privée et leur dignité.

44. Les questions cruciales pour les intermédiaires d’internet

et pour le grand public sont la qualité et la variété des informations,

ainsi que la pluralité des sources disponibles en ligne. Les intermédiaires

d’internet utilisent de plus en plus des systèmes algorithmiques,

qui peuvent être utilisés de manière abusive ou malhonnête pour

façonner les informations, les connaissances, la formation d’opinions

individuelles ou collectives et même des émotions et des actions.

Associé à la puissance technologique et économique des grandes plateformes,

ce risque devient particulièrement grave.

45. L’utilisation de l’intelligence artificielle et des filtres

automatisés pour la modération des contenus n’est ni fiable ni efficace.

Les grandes plateformes ont déjà un lourd passif de décisions de

modération erronées ou préjudiciables à l’égard de contenus terroristes

ou extrémistes. Les solutions aux défis politiques que sont les discours

de haine, la propagande terroriste et la désinformation sont souvent

multifactorielles. Il importe également de bien identifier et préciser

le rôle et la présence nécessaire des décideurs humains, ainsi que

la participation des utilisateurs dans l'élaboration et l’évaluation

des politiques de modération de contenu.

46. Aujourd'hui, on observe une tendance à la réglementation des

plateformes de médias sociaux. Le législateur devrait chercher à

renforcer la transparence et se concentrer sur les processus et

les opérations des entreprises plutôt que sur le contenu proprement

dit. En outre, la législation devrait lutter contre les contenus

illicites et éviter d'utiliser des notions plus larges telles que

les contenus préjudiciables.

47. Si les législateurs choisissent d'imposer des réglementations

très lourdes à tous les intermédiaires d’internet, y compris les

nouvelles petites entreprises, cela pourrait consolider la position

des grands acteurs qui sont déjà sur le marché. Dans un tel cas,

de nouveaux acteurs auraient peu de chance d'entrer sur le marché.

Par conséquent, il est nécessaire d'adopter une approche progressive,

pour adapter différents types de réglementations aux différents

types de plateformes.

48. Les États membres doivent trouver un équilibre entre la liberté

des entreprises économiques privées et leur droit de développer

leurs propres stratégies commerciales, incluant l’utilisation de

systèmes algorithmiques, et le droit du grand public de communiquer

librement en ligne, en ayant accès à un large éventail de sources

d’information.

49. Enfin, les intermédiaires d’internet devraient assumer des

responsabilités spécifiques concernant la protection des utilisateurs

contre la manipulation, la désinformation, le harcèlement, les discours

de haine et toute expression portant atteinte à la vie privée et

à la dignité humaine. Le fonctionnement des intermédiaires d’internet

et les évolutions technologiques qui sous-tendent leur mode opératoire

doivent être guidés par des principes éthiques élevés. D’un point

de vue juridique et éthique, les intermédiaires d’internet doivent

assumer leurs responsabilités pour garantir un flux d’informations

en ligne libre et pluraliste, respectueux des droits humains.

50. Le projet de résolution que j'ai préparé s'appuie sur ces

considérations.